-

自作IM akaza の 0.2.2 を出した2026-02-04(Wed)

-

linux のキーリマッパーは keyd がいいかも2026-02-02(Mon)

-

home-manager で dotfiles をリンクさせるのをやめた2026-02-01(Sun)

-

Dashyard2026-01-31(Sat)

-

difit を使い始めた2026-01-30(Fri)

-

ブログの編集画面を htmx から preact にした2026-01-29(Thu)

-

marisa-trie を rust に移植してみた2026-01-28(Wed)

-

og:image 生成するようにした2026-01-28(Wed)

-

`devbox search yq` とかしたときに詳細がわからなすぎたときの対策で調べることも出来るが詳細がなにもわからない。。

-

Pop! OS で、入力ソースを追加する

-

ogp を設定した2026-01-26(Mon)

-

開発者間でツールのバージョンをそろえられる devbox 使い始めた開発時に、`go install` とかで go で書かれたツールをちょいちょい入れてたんだけど、go 自体のバージョンを mise で上げたら再インストールする必要があってダルかった。 を参考に2026-01-26(Mon)

-

モニタリングスイート連携を追加した SakPilot 0.0.11 をリリースした

-

AeroSpace やめて HammerSpoon でウィンドウ管理することにしたAeroSpace ちょっと使ってたんだけど、、よく考えると別にタイル型ウィンドウマネージャーそんなに好きじゃ無いかもって思って、構成変えました。 俺、本当はタイリングよりも ratpoison 好き2026-01-25(Sun)

-

ソリティアを実装したclaude codeで。 ウェブで遊べる。github pages にデプロイされてる。 vite, TypeScript。 なんでわざわざ作ったかというと、特に理由はなくて、mineswe2026-01-24(Sat)

-

DB スキーマのマイグレーションをオブジェクトストレージ経由で行う dbmate-deployer を作ったやりたいこととしては、以下の通り。 * DB の schema migration をサーバーにログインせずに行いたい。 * github actions からは DB に直接アクセスしたくない2026-01-23(Fri)

-

Aerospacei3 系のタイルウィンドウマネージャー。Mac 用。 JankeyBorders も入れる。 ghostty は aerospace と相性が悪くて、タブごとにウィンドウとして扱えるという地獄のよ2026-01-20(Tue)

-

AI で nix に移行する、Vibe nix してみた去年、nix 使ってみようと思ったけど謎エラーが出て諦めてしまっていた。 nix だとDSLを覚える必要がある上に、エラーメッセージがあんまり親切じゃないので、エラーになりすぎて諦めてしまっていた。2026-01-20(Tue)

-

ターミナルを wezterm に戻すAerospace だと ghostty も alacritty も挙動不審でタブごとにウィンドウが生成されてしまって使いにくすぎるんで、Wezterm に戻した。 まさか、ウィンドウマネージャのた2026-01-17(Sat)

-

aerotag を使おうと思ったけど挫折して自前でゴリゴリ書いたを見て、aerotag 良さそうじゃん、と感じた。 ワークスペースにそれぞれ割り付けるよりも、モニターごとにワークスペースを固定して、アプリケーションごとに表示/非表示を切り替えるというのがよさそう2026-01-14(Wed)

-

AutoRaisetypo さんのブログで知った。 で、コレ便利っぽいんだけど、レポジトリに dmg があるのでそれを使うのが一番良さそうだった。 homebrew のレポジトリからインストールすると、権限付2026-01-13(Tue)

-

mkpasswd を mac で使うcloud-init とかに使うためのパスワードのハッシュ化をしたいときは、docker でやるのが楽でよさそう。 ```shell docker run -it --rm debian bash2026-01-07(Wed)

-

neovim の設定を見直す 2026年1月の陣書こうかな、と。 それにあたって、 neovim 周りの設定を全体的に見直し。 - lazy.vim を導入 - vim-plug を使っていたのを lazy.nvim に。 - clau2026-01-06(Tue)

-

blog4 admin での検索が微妙だったのを直したスマホから検索ができてない。と思ったが、、そもそも PC でも検索できてなかった。 E2E テストを playwright でも再実装させたので、これでもう壊れないことでしょう。2026-01-05(Mon)

-

otelcol の receiver/fluentforward に PR 送ったのがマージされたreceiver/fluentforward には問題があった。otelcol では SIGHUP を送ると既存のコネクションを閉じて、新しいコネクションを開き直さないといけないのだが、それが r2026-01-05(Mon)

-

deskpad良さそう。試してみたい。 ```sh brew install deskpad ``` でインストール完了。 `/Applications/Deskpad.app` が出来る。 もう一枚仮2026-01-03(Sat)

-

Best Buy 2025# Amazon Fire HD 8 Kids Pro 子ども用のタブレット。自分のアカウントで買った本を子供用アカウントに貸与したりすることも可能で便利。 サブスクで子ども用コンテンツも色々渡せ2026-01-03(Sat)

-

oxcrust 製の js toolkit。良さそう。 次回は biome じゃなくて oxc 使ってみようかな?2025-12-29(Mon)

-

blog4 の 2025 年末大改修。htmx ベースへの移行。現行のブログシステムは blog4 という名前になっている。基本的には実装するプログラミング言語を変えるタイミングで名前を変えていて、現在の世代は Go で書かれている。 ## API 周りを ty2025-12-29(Mon)

-

colimaを使うdocker desktop じゃなくて colima にしようかな、と。 ``` brew install colima docker brew services start colima ```2025-12-26(Fri)

-

2025年末の homebrew 大掃除``` ❯ brew list ==> Formulae abseil harfbuzz libxcb prometheus act helix libxdmcp protobuf2025-12-24(Wed)

-

zellij を始めるzellij は tmux とか GNU screen のようなターミナルマルチプレクサ。rust で書かれてるっぽくて、UI がリッチ。 昔は GNU screen を使っていて、最近は tmux2025-12-24(Wed)

-

debug-httpd に sleep と status のエンドポイントを作った$DAYJOB でコンテナ実行環境を作成していたわけですが、その際に動作確認のために必要なコンテナイメージとして作っていたのが debug-httpd です。 環境変数やサーバー側の情報を返すエ2025-12-19(Fri)

-

if your ultimate hacking keyboard 80 doesn't workupdate the firmware! USB dongle can update the firmware with the UHK Agent2025-12-17(Wed)

-

ボダラン4やったラファで一通り。 安定してボダラン、という感じで良かった。2025-12-10(Wed)

-

curl で DNS resolve の IP だけ差し替える``` --resolve ホスト名:ポート番号:IPアドレス ``` see2025-12-08(Mon)

-

ansible 2.19.0 以後で `skipping vars_file item due to an undefined variable` が出るときansible 2.19.0 以後では variable の validation が以前よりも strict になっている。 結果として、 ``` - hosts: foo become: t2025-12-08(Mon)

-

Outer Worlds 2 をクリアシステムとしては Outer World と同じ感じ。Fallout 風味のFPS RPG。アクションは前作とそんなに変わらず。 ストーリーがOuter World 1 の方が楽しかったかなぁ。あんま2025-11-17(Mon)

-

nip.io & sslip.io が便利`52.0.56.137.nip.io` のようにすると `52.0.56.137` が A レコードで引けるような DNS サーバー。2025-11-14(Fri)

-

testify の require.Eventually が便利テストを実装する際に、ミドルウェアの起動を待って何回かリトライしたい場合がある。そういう場合には tesitfy の require.Eventually が便利。 ```go require.Ev2025-11-14(Fri)

-

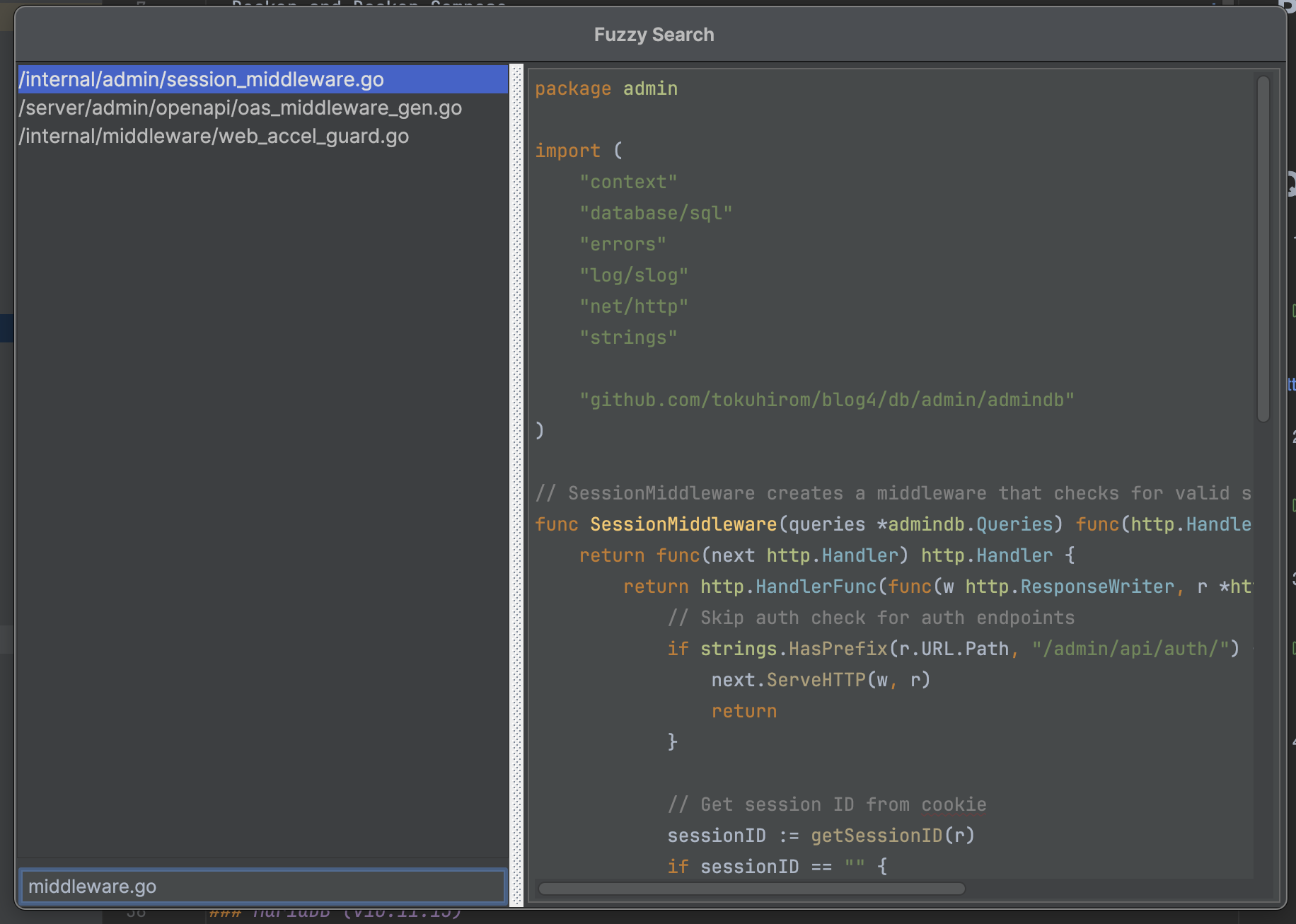

Fuzzier という JetBrains 系IDE で使えるプラグインが便利2025-10-06(Mon)

-

冷やし C# 始めましたC# が話題だったので、改めて hello, world から入っていきます。 ```sh brew install dotnet-sdk ``` から入っていきます。 ``` ❯ dotne2025-09-19(Fri)

-

G-SHOCK DW-H5600-2JR を購入2025-09-14(Sun)

-

fluent-bit の out_opentelemetry の通信部分のコードこのへんにありました。2025-09-01(Mon)

-

ashron という coding agent を作っているコーディングエージェントの乗り換えに右往左往するよりは、自分で作った方が楽しいというか、今の段階なら自分で作ったりして遊べる期間な気がするので、作ってみている。 golang で bubblete2025-08-30(Sat)

-

systemd の RuntimeDirectorysystemd には RuntimeDirectory という機能がある。service 起動時にディレクトリを作ってくれる。 `/run/` 以下にディレクトリを置いて、unix socket2025-08-19(Tue)

-

goland で wsl2 を使う方法に設定マニュアルがある。 色々と書いてあるが、Ubuntu を使う場合、普通に WSL2 をセットアップし、WSL 領域にクローンしたプロジェクトを使えば普通に動く。 ということになる。 もっ2025-08-17(Sun)

-

uAutopagerize を入れるGPD Win では、カーソルの移動が通常のPCよりも操作性が悪いため、記事を読む効率を上げるために uAutopagerize を入れる。 ちなみに、プライベートではブラウザは Firefox2025-08-16(Sat)

-

GPD Win で feedly を読むfeedly をリビングでサクサク読みたいが、ノートPCは、諸般の事情で持ち込みづらいため、GPD in 5 を導入する。 feedly はショートカットキーを使うのが便利なわけだが、gpd win2025-08-16(Sat)

-

docker を snap で入れると制約が多いこのへん。 デスクトップでなんとなくコンテナを動かすぐらいにしか使う予定がなかったマシンだったので、なんとなく snap を使って docker をインストールしたのだけど、最近は dcv とい2025-08-16(Sat)

-

dcv を homebrew-tap に対応させたdocker container の様子を見る TUI ツールである dcv というツールを作っている今日この頃。 なかなか便利になってきているのだが、インストールが面倒だった。 そこで、gorel2025-08-12(Tue)

-

UHK60 が bricked したけどファームウェアがリカバリできて助かった話ちょっと、自分が UHK 60 に最適化されすぎていて他のキーボードだとかなり厳しいという状況になっている。 ショートカットキーが無限に設定できて最高便利すぎるので。。親指の位置にトラックパッドが置い2025-08-12(Tue)

-

さくらのクラウドのモニタリングスイートのサンプルコードを書いたOtel を使うサンプルが公式ドキュメントに無かったので書いて置いておきました。 テスト用にダミーデータを生成するスクリプトも同梱しています。2025-08-11(Mon)

-

Psycopg 3AI が 2 出してくるから 2 使ってたけど 3 出てた。2025-08-01(Fri)

-

開発に使う Python スクリプトは uv で管理する```python3 #!/usr/bin/env -S uv run --script # /// script # requires-python = ">=3.11" # dependencie2025-07-24(Thu)

-

スナイパーエリートレジスタンスクリア2025年7月17日に一通りクリア。シャープシューターでさっくりと。 毎度のことながら、序盤が厳しい。静音スナイパーとかが揃ってからが本番、という感じ。 良くも悪くも毎回同じ味がするゲーム。 最終2025-07-18(Fri)

-

postgresql の docker image は初期化後に再起動するpostgresql の公式 docker イメージは、`/docker-entrypoint-initdb.d` にファイルを置くことで初期化出来る。 postgresql のイメージは初期化2025-07-16(Wed)

-

/tmp がファインダーで勝手に開かれる怪現象なんか最近、 /tmp に sysdiagnose_2025.07.09_11なんとかかんとか.tar.gz が作られて Finder で /tmp がオープンされるっていう謎の挙動が起きてて困ってた2025-07-09(Wed)

-

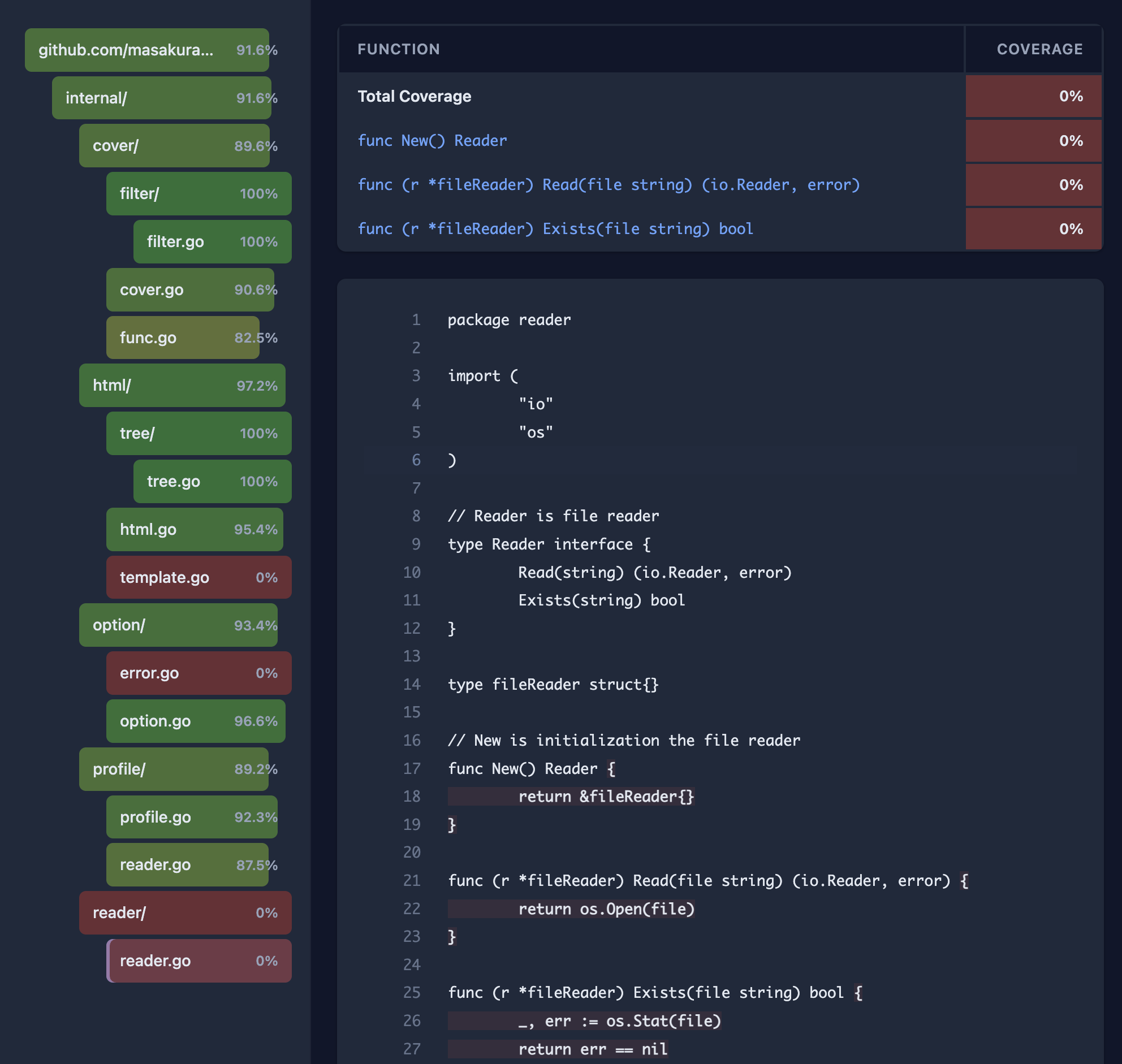

【取り込み済み】gover-html の見た目をよくする PR を送った2025-07-06(Sun)

-

gover-html に font-family を指定する PR を出した`go tool cover -html` の出力が素朴すぎるのでもう少しリッチな表現をしてくれるツールないかなぁと探していた。 探していたところ、[gocov]( + gocov-html が良さそ2025-07-04(Fri)

Prev